Instinct:全面进军深度学习领域

去年年末,AMD发布了采用VEGA架构的首款GPU,它不是专业卡也不是游戏卡,而是主打深度学习的加速卡,其名为Radeon Instinct MI25,这也是AMD头一次为加速卡单独开辟一个系列。Radeon Instinct其实准确说来是一个完整的体系,底层基于新的硬件加速卡,结合ROCm开源软件平台(支持x86/ARM/Power平台并可导入CUDA应用),再辅以优化的机器学习和深度学习框架、应用,可广泛服务于云、大规模数据中心、金融服务、能源、自动驾驶等领域。Radeon Instinct系列的诞生表明AMD也要紧跟时代潮流,全面进军机器智能和人工智能的市场。

Radeon Instict加速卡

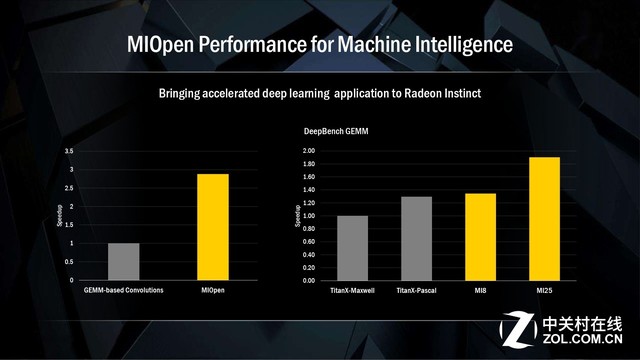

Radeon Instinct MI25作为Instinct家族的最强音,其性能也是对得起头牌之名。在百度开源深度学习硬件基准DeepBench GEMM对比图上我们可以看到,Radeon Instinct MI25的性能高出NVIDIA TITAN X Pascal约46%,由于当时NVIDIA TITAN Xp还没有发布,根据性能推测,MI25还是要超过后者约10%的。之所以能有这么大的领先优势,主要原因是AMD的VEGA架构加入了快速堆叠运算(Rapid Packed Math/RPM),其可以在单个FP32 ALU内处理一对FP16浮点操作,如果两个FP16操作彼此兼容的话,就可以打包到一起作为FP32进行处理,由此带动峰值吞吐能力的翻倍。因此我们看到,MI25的FP16高达25 TFLOPS,达到了FP32的两倍。

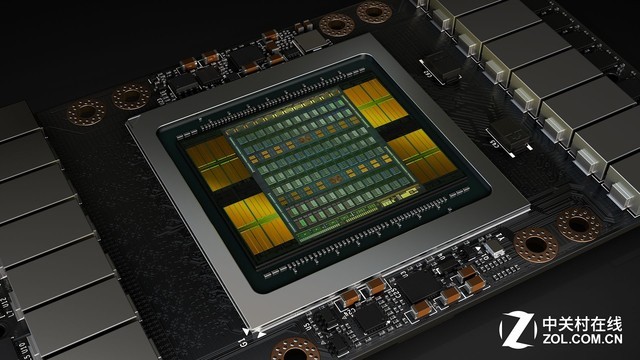

AMD本以为胜券在握,可没想到NVIDIA在今年5月便放出了更新更快的加速卡——Tesla V100,这款加速卡不仅有着高达15 TFLOPS的史上最高单精度性能,还有着专为深度学习打造的Tensor Core,其可提供120 TFLOPS 的浮点张量运算性能,具体来说,在深度学习的推断方面,相比于Tesla P100上的FP16操作,其可以实现最高6倍速的峰值TFLOPS,这也就是说在深度学习能力上,V100是有着压倒性的优势的。

此外,这两个GPU都支持16GB HBM2,但是V100能够支持900Gbps的存储带宽,这几乎是MI25的484Gbps存储带宽的2倍,更不用说NVLink带来的性能加成了,而MI25同V100相比唯一的优势就剩价格了。综上所述,Instinct的确为AMD开辟了一条顺应时代的新出路,但同深耕AI和深度学习多年的NVIDIA相比,这只能算是起步。

本文属于原创文章,如若转载,请注明来源:能否成功逆袭?AMD GPU战略及市场剖析//vga.zol.com.cn/652/6528819.html